Do jornal O Globo

Prática que já vem chamando a atenção de órgãos fiscalizadores desde as últimas eleições, os conteúdos gerados por inteligência artificial ganharam um nível de sofisticação que promete elevar a preocupação a outro patamar em 2026.

Especialistas reforçam que vídeos ultrarrealistas, produzidos com imagens manipuladas — como os que circularam recentemente sobre o papel do presidente Lula e de integrantes do governo no escândalo dos descontos indevidos do INSS, ou de anúncio de impostos que nunca existiram e até de uma proposta de Bolsa Família para mães de bebês reborn — têm alto potencial de alterar o resultado de uma eleição.

Leia mais

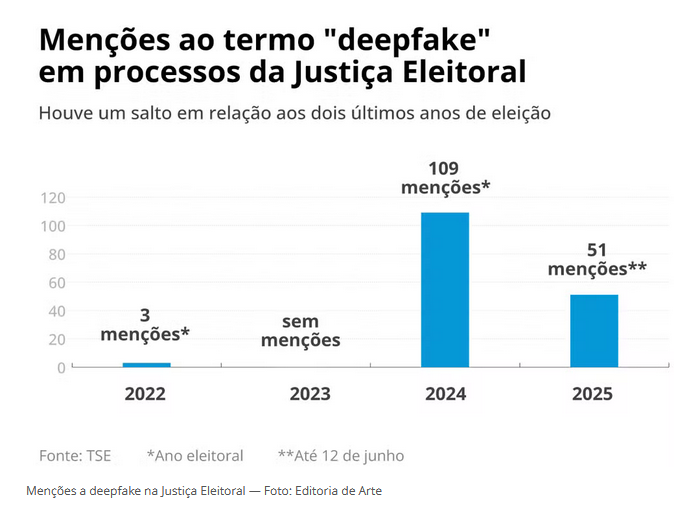

Na Justiça Eleitoral, os processos que mencionam as deepfakes, nos quais se encaixam os conteúdos de desinformação de IA, deram um salto de 2022 para 2024, anos eleitorais — foram três ações no primeiro contra 109 no segundo, de acordo com o Diário Eletrônico da Justiça. Neste ano, já são 51 processos, e a tendência é que esses números se multipliquem até o ano que vem, explica a professora da USP e pesquisadora sobre IA generativa Pollyana Ferreira:

— Desde o lançamento do ChatGPT em 2022, vimos um salto na quantidade dessas ferramentas, que também têm ficado mais baratas, transformando o uso desses recursos mais acessível a qualquer cidadão comum. Antes, para produzir um conteúdo falso, era preciso o investimento de muito mais dinheiro, o envolvimento do trabalho de uma pessoa especializada para editar, por exemplo, uma foto em uma capa de uma revista ou jornal. Hoje, nada mais disso é necessário.

Presidente como alvo

Outro diferencial, ela explica, é a facilidade com que voz e imagem são geradas e sincronizadas, tornando os conteúdos falsos ainda mais realistas e com maiores chances de viralização. Esse combo está em vídeos que circulam pelo TikTok, como os que usam trechos da fala da jornalista Renata Vasconcellos, âncora do “Jornal Nacional”, para anunciar a falsa descoberta de um quarto secreto do presidente Lula para “guardar o dinheiro roubado dos aposentados”.

Nas últimas semanas, também têm sido veiculadas deepfakes de Lula anunciando a criação de uma categoria do Bolsa Família para atender “mães de bebês reborn”. O vídeo foi criado a partir da manipulação de trechos da entrevista que o presidente deu ao podcast Podpah, em 2021. A informação precisou ser desmentida pelo Ministério do Desenvolvimento Social, pasta responsável pelo programa, em um post nas redes sociais que dizia que o benefício estaria disponível “só para (mães de) bebês de carne e osso”.

Ainda no início deste ano, o ministro da Fazenda, Fernando Haddad, também precisou vir a público desmentir um vídeo em que ele, após a alteração do conteúdo pela IA, fazia o anúncio de impostos sobre “cachorrinhos de estimação e grávidas”. O conteúdo chegou a ser compartilhado pelo deputado federal Osmar Terra (MDB-RS), que foi ministro da gestão de Jair Bolsonaro, e circulou em meio à crise do Pix, que derrubou a aprovação do governo na época.

Em resposta, a Advocacia-Geral da União (AGU) exigiu retirada, em 24 horas, do conteúdo de circulação das redes sociais da Meta. A solicitação foi um dos 12 pedidos extrajudiciais feitos pelo órgão, desde 2023, para remoção de conteúdos falsos e que foram deferidos. No mesmo período, três foram negados e outros três estão sob análise das plataformas; quatro viraram processos que serão analisados pelo Judiciário.

Na semana passada, o Supremo Tribunal Federal (STF) formou maioria a favor da responsabilização das redes sociais por conteúdos ilegais publicados em suas plataformas, durante o julgamento do Marco Civil da Internet. Isso significa que as big techs não precisarão aguardar uma decisão judicial para remover conteúdos falsos.

O Tribunal Superior Eleitoral (TSE) se manifestou pela primeira vez sobre uso de inteligência artificial no ano passado. A Corte determinou que o uso da ferramenta é liberado desde que haja um aviso na publicação de que aquele conteúdo foi gerado por IA; as deepfakes são terminantemente proibidas. Desde então, denúncias de adulterações de imagens e áudios foram investigadas pela polícia e chegaram ao Judiciário em estados como São Paulo, Amazonas, Rio Grande do Sul, Sergipe, Mato Grosso do Sul, Maranhão e Tocantis.

— Observamos que, em disputas eleitorais mais acirradas ou com candidatos maiores, a Justiça Eleitoral se via despreparada e sem instrumentos para fazer uma análise mais técnica sobre essas ocorrências de deepfake — diz Stefani Vogel, advogada e uma das autoras do estudo Ethics 4IA, do Instituto Brasileiro de Ensino, Desenvolvimento e Pesquisa (IDP) sobre o tema. — Isso nos preocupa porque a tendência é que esses casos aumentem no ano que vem, e nós devemos ficar novamente nas mãos do TSE, que deve aperfeiçoar a solução pensada para essas ocorrências.

Procurado, o TSE afirmou que prevê a aprovação de novas resoluções, que orientam o andamento das eleições, no início do ano que vem, assim como em pleitos anteriores.

O levantamento Ethics 4IA analisou no ano passado 56 processos sobre deepfakes que chegaram aos Tribunais Regionais Eleitorais: 34 (60%) permaneceram na Justiça Eleitoral e 14 ocorrências (25%) foram encaminhadas para análise da Justiça comum. Para Stefani, isso reflete “o despreparo de operadores de Direito” para lidarem com esses casos.

Cientista político pela Universidade de Brasília (UnB), Murilo Medeiros teme que o uso irresponsável de IA mine a confiança nas urnas e “macule o processo eleitoral”, alimentando narrativas conspiratórias contra a democracia:

— Simular falas, comportamentos e os posicionamentos dos candidatos pode induzir o eleitor ao erro. Uma saturação informacional no ambiente digital, com conteúdos manipulados, influencia e enfraquece a confiança da população no sistema eleitoral.

Uma das ferramentas que passaram a preocupar analistas e especialistas em cybersegurança é a Veo3, lançada pelo Google em maio e capaz de produzir vídeos realistas a partir de pequenos comandos de texto. A plataforma explica, contudo, que a ferramenta não permite a geração de pessoas identificáveis e que “qualquer conteúdo gerado com a IA do Google possui uma marca d’água SynthID incorporada e uma marca d’água visível”.

No Congresso, projetos para tentar regular o uso de IA no país estão em tramitação. No Senado, Chico Rodrigues (PSB-PR) propôs um que prevê o aumento de crimes contra a honra cometidos com o uso de deepfake e outro que regula o uso publicitário de tecnologias de IA, ambos travados em comissões da Casa. Já na Câmara, está em pauta uma proposição mais generalista, que trata da regulamentação da IA, ainda em fase de audiência pública.

Reflexos no mundo

O impacto eleitoral pelo uso irresponsável de IA foi verificado há três semanas na Argentina, durante as eleições da Câmara dos Vereadores de Buenos Aires, quando um vídeo manipulado mostrou o ex-presidente Mauricio Macri reconhecendo de antemão a derrota da chapa de seu partido e pedindo votos para a legenda de Javier Milei, que levou a maioria na Casa. Um episódio parecido aconteceu durante as eleições presidenciais no país há dois anos, quando também circularam imagens adulteradas que mostravam o principal adversário de Milei, o ex-ministro da Economia Sergio Massa, cheirando cocaína.

Uma situação similar aconteceu no ano passado nos Estados Unidos, no estado de New Hampshire. Na véspera das primárias democratas, circularam áudios falsos do ex-presidente Joe Biden pedindo para a população “ficar em casa” e “guardar o voto para novembro”, quando aconteceram as eleições principais. Apesar disso, ele venceu como candidato democrata no estado.

Outro caso ocorreu na França, quando foram criadas nas últimas eleições contas falsas no TikTok para personalidades de IA que fingiam ser “sobrinhas” de Marine Le Pen. Na época, o caso foi noticiado pela imprensa local como uma tentativa de aproximar a candidata a grupos de eleitores mais jovens, segmento no qual o presidente reeleito, Emmanuel Macron, era mais popular.

Leia menos